Um im KI/AI Bereich Modelle zu testen, gibt es verschiedene Möglichkeiten.

Für lokale Tests ohne großes Hosting empfehle ich ollama

Nach der Einrichtung bekommt man das ganze mit einem simplen:

docker-compose up -dgestartet.

Über ein Webinterface kann man bequem die Modelle installieren und im Chat-Interface mit den Modellen agieren, eine REST-API steht auch zur Verfügung um via curl seine Requests zu machen.

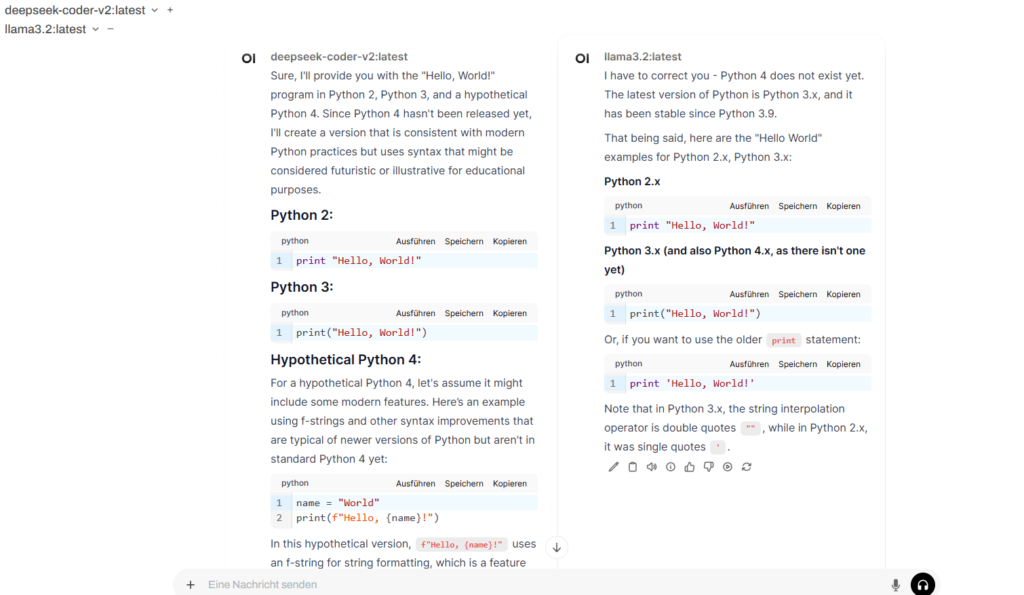

Da gerade DeepSeek in aller munde ist, hab ich mal einen Direktvergleich zu einem llama 3.2 Modell gestartet und bin begeistert von der Detail-tiefe und Geschwindigkeit von DeepSeek.

Habt Ihr damit schon experimentiert?

Hier seht Ihr wie das Modell „Hello World“ in Python lösen würde.

0 Comments