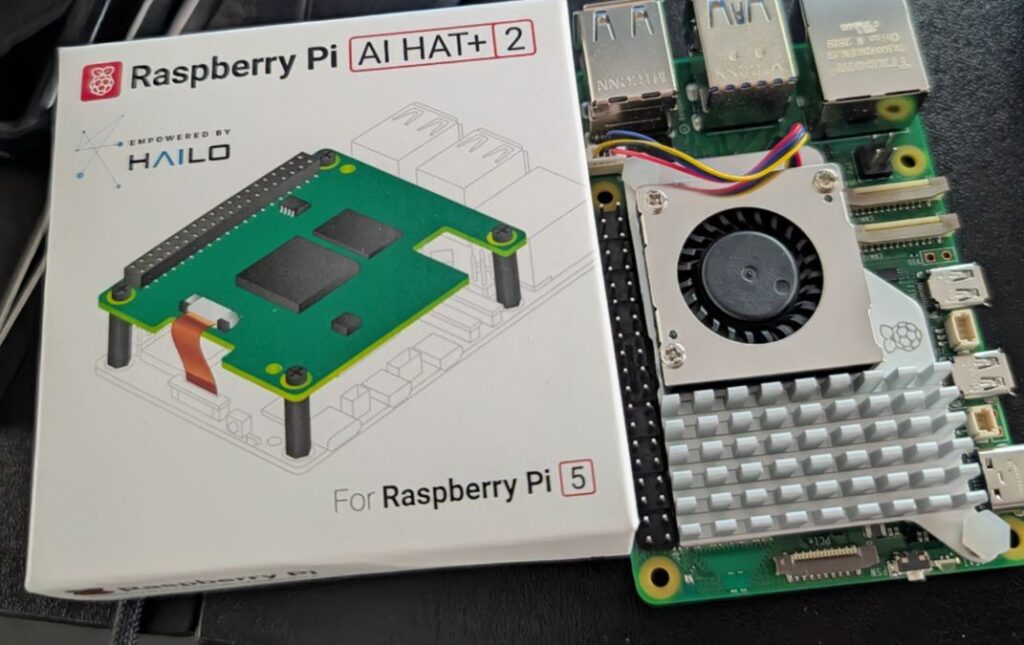

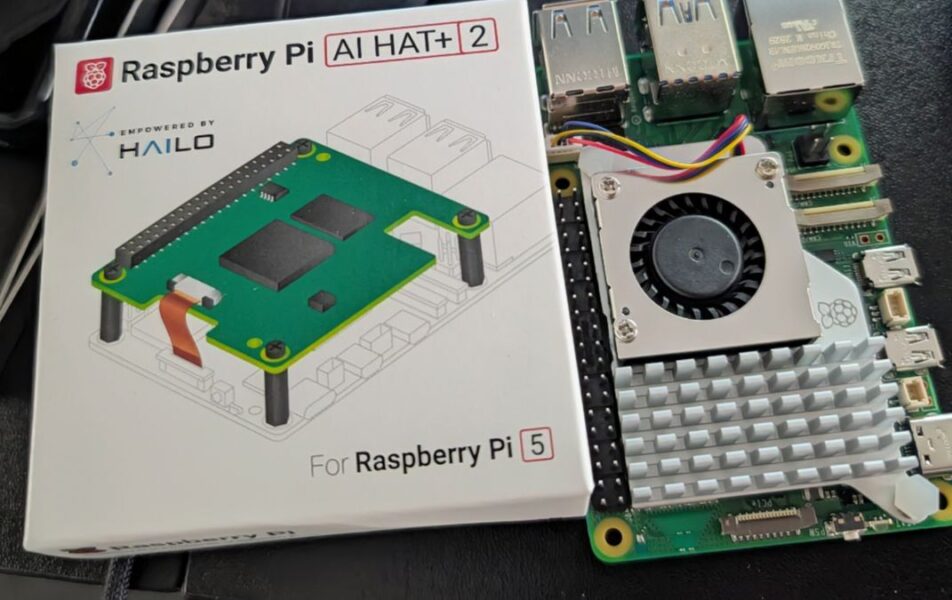

Ich habe den neuen Raspberry Pi AI HAT 2 +auf meinem Pi 5 getestet.

Dank der Hailo-Hardware-Beschleunigung und den 8GB RAM direkt auf dem Modul fühlt sich lokale KI endlich nicht mehr nach einem Kompromiss an.

Klar, 1B-Modelle sind kompakt, aber erst mit dieser Hardware-Power machen Projekte wie self-hosted Whisper oder SDXL richtig Spaß. Die Geschwindigkeit ist beeindruckend – keine Cloud, keine Latenz, einfach nur lokale Performance.

Wie sind eure Erfahrungen mit solchen Edge KI Anwendungen?

Fazit:

Gerade wenn man whisper, sdxl oder eben ollama mit tiny models nutzen möchte, dann kann der AI HAT einen mehrwert bringen. https://www.raspberrypi.com/documentation/accessories/ai-hat-plus.html

Beispiel Anwendungen kann man auch hier installieren: https://github.com/hailo-ai/hailo-apps

0 Comments